掌握 PyTorch 分布式加速训练秘籍,提升游戏性能

在当今的手游领域,优化训练过程以提升游戏性能至关重要,而 PyTorch 的分布式设置为加速训练提供了强大的支持。

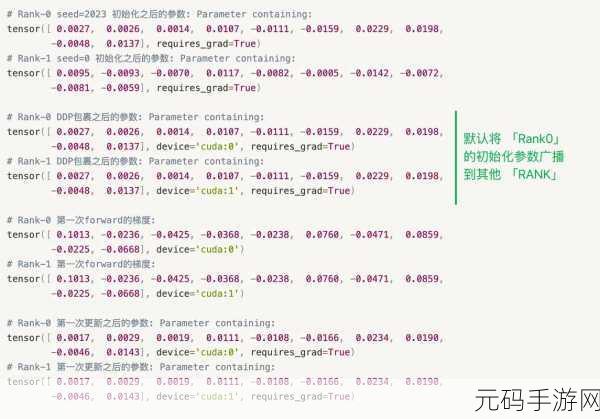

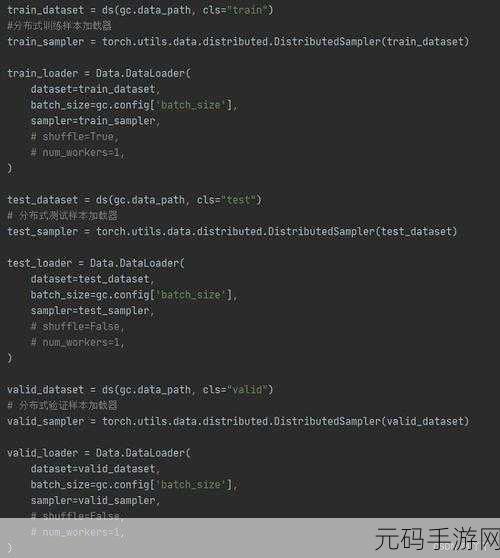

想要充分发挥 PyTorch 分布式训练的优势,首先要了解其基本原理,分布式训练通过将计算任务分配到多个计算节点上,实现了并行处理,从而大大缩短了训练时间,这意味着在相同的时间内,可以进行更多次的训练迭代,优化模型效果。

在实际应用中,合理配置硬件资源是关键的一步,确保各个计算节点的性能均衡,避免出现某个节点成为瓶颈,影响整体训练效率,要根据游戏的需求和数据规模,选择合适的分布式策略,如数据并行、模型并行或混合并行。

网络通信的优化也不能忽视,高效的通信机制能够减少数据传输的延迟和开销,进一步提升训练速度,采用合适的通信协议和优化通信参数,可以让数据在节点之间快速、稳定地传输。

对模型结构的调整也是必不可少的,通过精简模型参数、优化算法等方式,降低计算复杂度,使模型在分布式环境中能够更高效地运行。

在进行 PyTorch 分布式训练时,还需要注意错误处理和监控,及时发现并解决训练过程中出现的问题,保障训练的稳定性和可靠性,通过监控训练指标,如准确率、损失值等,可以直观地了解训练效果,及时调整策略。

熟练掌握 PyTorch 加速训练的分布式设置,对于提升手游的性能和质量具有重要意义,开发者们应不断探索和实践,为玩家带来更优质的游戏体验。

参考来源:相关技术文档及行业研究报告。