探秘 Spark 计算框架,容错性增强秘籍大公开

在当今数字化时代,数据处理和计算的需求日益增长,Spark 计算框架作为一款强大的工具,其容错性的增强至关重要,本文将深入探讨 Spark 计算框架如何增强容错性,为您揭开这一神秘面纱。

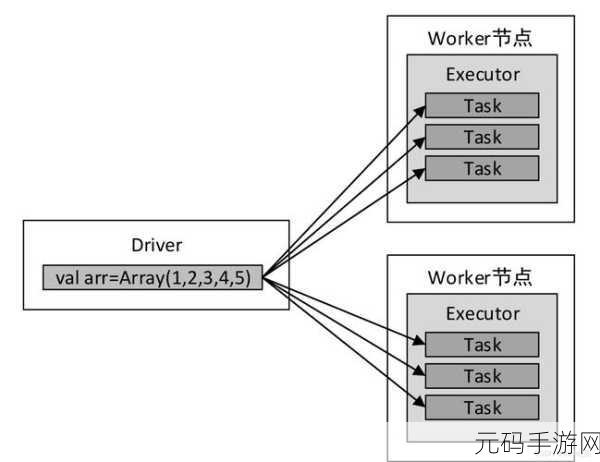

Spark 计算框架之所以需要增强容错性,是因为在大规模数据处理过程中,各种意外情况随时可能发生,例如硬件故障、网络延迟、节点宕机等,这些都可能导致计算任务的中断或出错,如果不能有效地处理这些错误,将会严重影响数据处理的效率和准确性。

Spark 计算框架是通过哪些方式来增强容错性的呢?首先是数据的备份和恢复机制,Spark 会在数据处理过程中自动对关键数据进行备份,当出现故障时,可以快速从备份中恢复数据,继续进行计算,其次是任务的重试机制,如果某个任务执行失败,Spark 会自动重试该任务,直到达到设定的重试次数或者任务成功执行为止,还有检查点机制,通过定期设置检查点,将计算的中间结果保存下来,一旦发生故障,可以从最近的检查点重新开始计算,避免从头开始,大大节省了时间和资源。

在实际应用中,如何有效地配置和利用这些容错机制呢?这需要根据具体的业务需求和场景来进行调整,对于对数据准确性要求较高的场景,可以增加数据备份的频率和副本数量,以确保数据的可靠性,而对于对计算时间要求较高的场景,可以合理设置任务重试次数和检查点间隔,以平衡容错性和计算效率。

Spark 计算框架的容错性增强机制为大数据处理提供了坚实的保障,了解和掌握这些机制,对于充分发挥 Spark 计算框架的优势,提高数据处理的质量和效率具有重要意义。

参考来源:相关技术文档及行业研究报告。