掌握秘籍!破解 PyTorch 图神经网络过拟合难题

在当今的人工智能领域,图神经网络凭借其强大的建模能力,在处理复杂关系数据方面展现出了巨大的潜力,过拟合问题却如同拦路虎一般,常常困扰着开发者和研究者,PyTorch 作为广泛应用的深度学习框架,如何在其基础上有效地防止图神经网络的过拟合,成为了一个关键的课题。

中心句:图神经网络在处理复杂关系数据方面有潜力,但过拟合问题困扰着开发者和研究者。

要解决 PyTorch 图神经网络的过拟合问题,我们首先需要深入理解过拟合产生的原因,过拟合通常发生在模型对训练数据过度学习,以至于无法很好地泛化到新的数据上,在图神经网络中,可能由于网络结构过于复杂、训练数据量不足、正则化手段使用不当等多种因素导致过拟合。

中心句:解决 PyTorch 图神经网络过拟合问题需先理解其产生原因,可能由多种因素导致。

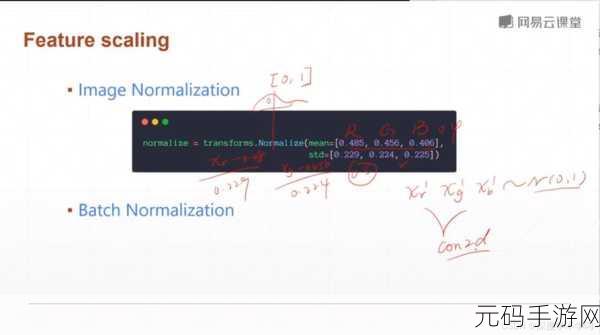

为了防止过拟合,数据增强是一种有效的策略,通过对原始数据进行随机变换、添加噪声等操作,可以增加数据的多样性,从而让模型学习到更具普遍性的特征,Dropout 技术也是常用的手段之一,它在训练过程中随机地将神经元的输出设置为 0,相当于让模型在不同的网络结构下进行学习,增强了模型的鲁棒性。

中心句:防止过拟合,数据增强和 Dropout 技术是有效策略,前者增加数据多样性,后者增强模型鲁棒性。

正则化也是不可或缺的一环,L1 和 L2 正则化可以对模型的参数进行约束,避免参数过大导致过拟合,早停法(Early Stopping)也是一种实用的技巧,通过监控验证集上的性能指标,在模型性能开始下降之前停止训练,防止过度训练。

中心句:正则化和早停法能防止过拟合,前者对模型参数约束,后者通过监控验证集停止训练。

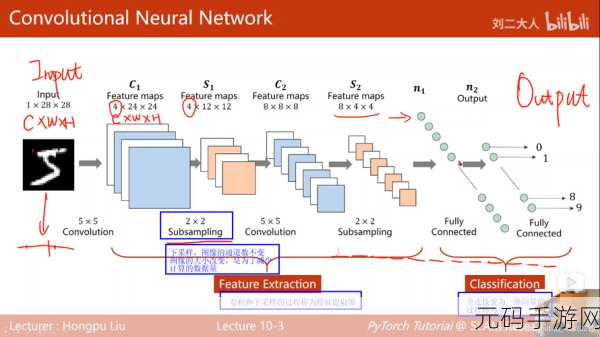

除了上述方法,选择合适的模型架构也至关重要,过于复杂的模型容易导致过拟合,而简单的模型可能无法捕捉到数据中的复杂模式,需要根据数据特点和任务需求,权衡模型的复杂度和表达能力。

中心句:选择合适的模型架构对防止过拟合很重要,要权衡复杂度和表达能力。

防止 PyTorch 图神经网络的过拟合需要综合运用多种方法,并不断进行试验和调整,只有在实践中不断探索和优化,才能让图神经网络发挥出最大的潜力,为解决各种实际问题提供有力的支持。

参考来源:相关学术研究及技术文档。

仅供参考,您可以根据实际需求进行修改和调整。