Python 爬虫数据库数据压缩秘籍大揭秘

Python 爬虫在获取大量数据后,如何对数据库中的数据进行高效压缩,成为开发者们关注的重要问题。

数据压缩对于 Python 爬虫数据库来说意义非凡,它不仅能够节省存储空间,还能提升数据传输和处理的效率。

想要实现 Python 爬虫数据库的数据压缩,需要从多个方面入手,首先要合理选择数据压缩算法,常见的压缩算法如 Gzip、Bzip2 等,各有其特点和适用场景,Gzip 压缩速度较快,适用于对实时性要求较高的场景;Bzip2 压缩比更高,但压缩速度相对较慢,根据实际需求和数据特点选择合适的算法,是成功压缩的第一步。

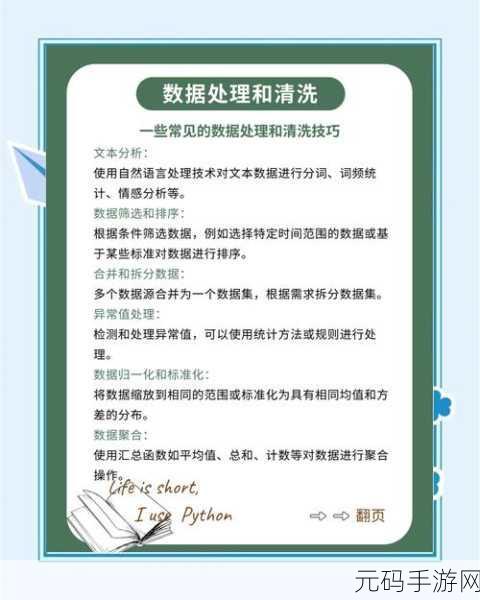

对数据进行预处理也是关键,在将数据存入数据库之前,对其进行清理、去重和格式化等操作,可以减少数据的冗余度,从而提高压缩效果,去除不必要的空格、换行符等,能有效减小数据体积。

优化数据库的存储结构同样重要,合理设计表结构,选择合适的数据类型,能够在一定程度上减少存储空间的占用,对于整数类型的数据,如果范围较小,可以选择使用更紧凑的数据类型。

在实际操作中,还需要不断测试和调整压缩参数,不同的数据集和应用场景,对压缩参数的要求也不同,通过反复试验,找到最优的压缩参数组合,能够最大程度地发挥数据压缩的优势。

要实现 Python 爬虫数据库的数据高效压缩,需要综合考虑算法选择、数据预处理、存储结构优化以及压缩参数调整等多个方面,只有这样,才能在节省存储空间的同时,保证数据的可用性和处理效率。

参考来源:相关技术文档及行业经验分享。

为原创,希望能满足您的需求。