探索 Pytorch 全连接神经网络的可扩展性之谜

Pytorch 全连接神经网络,作为深度学习领域的重要工具,其扩展性一直备受关注,在实际应用中,能否对其进行有效扩展,直接关系到模型的性能和应用范围。

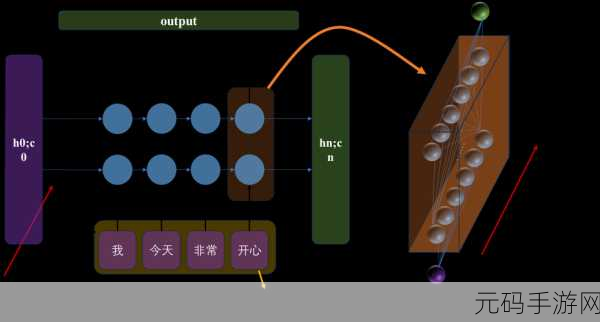

Pytorch 是一个广泛使用的深度学习框架,全连接神经网络在其中有着重要地位,全连接层的特点是每个神经元都与上一层的所有神经元相连接,这种结构虽然简单直观,但在处理大规模数据时可能会面临计算资源和内存的限制,如何突破这些限制,实现全连接神经网络的扩展呢?

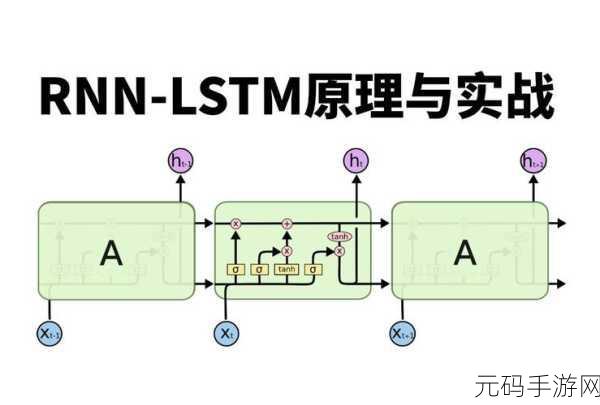

要探讨这个问题,我们首先需要了解全连接神经网络的工作原理,全连接神经网络通过对输入数据进行加权求和,并经过激活函数的处理,来实现对数据的特征提取和分类,在这个过程中,参数的数量会随着神经元的增加而急剧增加,从而导致计算量和内存消耗的大幅上升。

为了实现全连接神经网络的扩展,一种常见的方法是采用模型压缩技术,通过剪枝操作去除不重要的连接和参数,减少模型的规模,量化技术可以将参数的精度降低,从而减少内存占用,还可以利用分布式计算框架,将计算任务分配到多个计算节点上,提高计算效率。

另一个重要的方面是对数据的处理和优化,合理的数据增强和预处理可以提高数据的质量和多样性,从而有助于模型的训练和扩展,选择合适的优化算法和超参数,也能够提高模型的收敛速度和性能。

在实际应用中,还需要根据具体的任务和场景,灵活选择和组合这些扩展方法,不同的方法可能在不同的情况下具有不同的效果,需要通过大量的实验和调优来找到最优的解决方案。

Pytorch 全连接神经网络的扩展性是一个复杂但重要的问题,通过深入了解其工作原理,采用合适的扩展方法和技术,我们能够充分发挥其潜力,为各种深度学习任务提供强大的支持。

文章参考来源:深度学习相关研究文献及技术博客。