探秘 Hadoop 生态系统,高可用性的完美实现之道

Hadoop 生态系统,这个在大数据领域中举足轻重的存在,其高可用性的实现一直备受关注,到底如何才能达成 Hadoop 生态系统的高可用性呢?

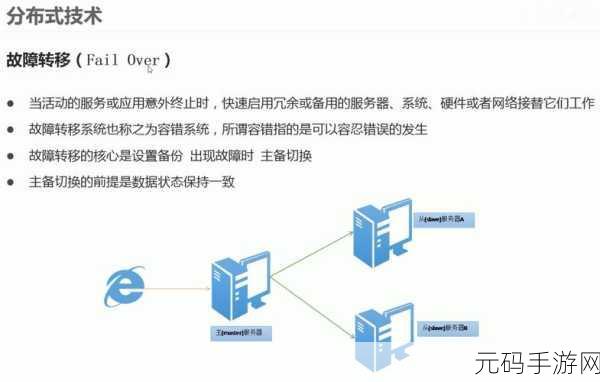

Hadoop 生态系统是一个复杂而强大的架构,要实现其高可用性并非易事,数据的备份与恢复机制是关键的一环,通过定期备份数据,并建立有效的恢复策略,能够在系统出现故障时迅速恢复数据,保障业务的连续性。

集群的监控与管理同样不可或缺,实时监测集群的状态,包括节点的运行情况、资源的使用情况等,能够及时发现潜在的问题,并采取相应的措施进行处理。

而在硬件层面,采用冗余的硬件设备也是保障高可用性的重要手段,多块硬盘组成 RAID 阵列,以防止单个硬盘故障导致数据丢失;多个电源供应,避免电源故障引发系统宕机。

软件的优化与升级也不能忽视,及时更新 Hadoop 及其相关组件的版本,修复已知的漏洞和问题,同时优化系统的配置参数,提升系统的性能和稳定性。

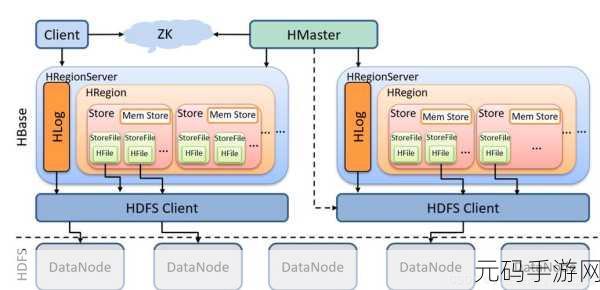

合理的架构设计也是实现高可用性的基础,根据业务需求和数据量,设计合适的集群规模和拓扑结构,确保系统能够应对各种负载情况。

要实现 Hadoop 生态系统的高可用性,需要从数据备份、集群监控、硬件冗余、软件优化和架构设计等多个方面综合考虑,采取有效的措施,才能确保系统的稳定运行,为大数据处理提供可靠的支持。

文章参考来源:相关技术文档及行业研究报告。

上一篇:国产精品视频,热门国风视频

下一篇:新不良人手游新手第四天开荒全攻略