掌握 PyTorch 加速训练的超参数精妙调整秘籍

PyTorch 作为一款强大的深度学习框架,在训练模型时,超参数的调整至关重要,合理地调整超参数能够显著提升训练效率和模型性能。

超参数调整并非一蹴而就,需要综合考虑多方面因素,比如学习率,它直接影响模型的收敛速度,过小的学习率会导致训练时间过长,而过大的学习率则可能使模型无法收敛。

在数据预处理方面,对数据进行适当的清洗、归一化和增强操作,能够为模型训练提供更优质的数据基础,从而影响超参数的效果。

模型的架构也与超参数调整紧密相关,不同的模型结构可能需要不同的超参数组合来达到最佳性能。

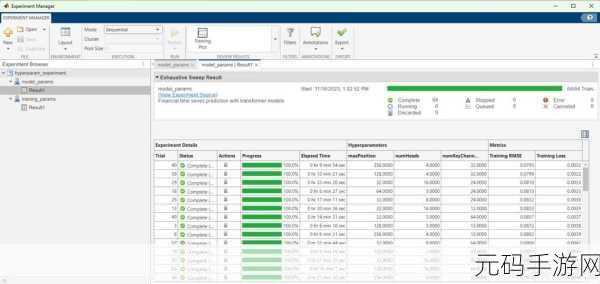

如何有效地进行 PyTorch 超参数调整呢?我们可以采用网格搜索的方法,通过设定一系列可能的超参数值组合,对每个组合进行训练和评估,从而找到最优的超参数组合,但这种方法计算成本较高。

另一种常用的方法是随机搜索,它在给定的范围内随机选择超参数组合进行训练和评估,虽然不一定能找到绝对最优解,但在大多数情况下能够找到较为满意的结果,且计算成本相对较低。

还有基于模型的超参数优化方法,例如使用贝叶斯优化算法,这种方法利用先验知识和模型评估结果来指导后续的超参数搜索,提高搜索效率。

要想在 PyTorch 中实现高效的训练,掌握超参数调整的技巧是必不可少的,不断尝试和实践,结合具体的任务和数据特点,才能找到最适合的超参数组合,提升模型的性能。

文章参考来源:相关深度学习技术文档及学术研究成果。