深入探究,Hadoop_Heapsize 内存需求之谜

Hadoop_Heapsize 对于内存的要求一直是开发者和使用者关注的焦点,它对内存的要求到底高不高呢?

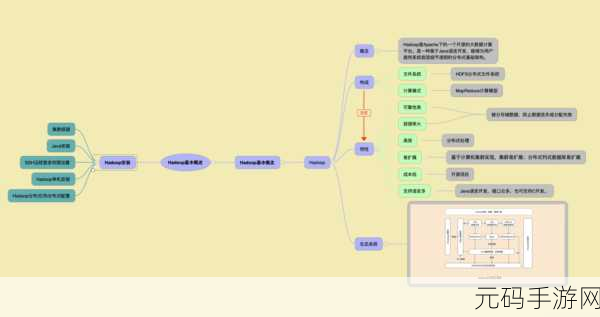

要搞清楚这个问题,我们需要先了解 Hadoop_Heapsize 的工作原理,Hadoop_Heapsize 是 Hadoop 框架中的一个重要参数,它主要用于配置 Java 虚拟机(JVM)的堆内存大小,在 Hadoop 处理大规模数据时,JVM 需要足够的内存来存储和处理数据,否则可能会出现性能下降甚至崩溃的情况。

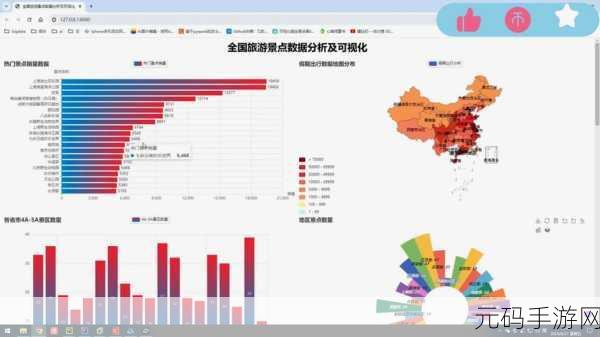

从实际应用场景来看,Hadoop_Heapsize 对内存的要求会因具体的业务需求和数据规模而异,对于处理少量数据的小型项目,可能并不需要过高的内存配置;但对于处理海量数据的大型项目,充足的内存是保证系统稳定运行和高效处理的关键。

在考虑 Hadoop_Heapsize 的内存需求时,还需要关注硬件环境,如果服务器的硬件配置较高,能够提供更多的物理内存,那么可以适当增加 Hadoop_Heapsize 的值,以充分发挥硬件的性能,反之,如果硬件资源有限,则需要谨慎配置,避免因内存不足导致系统出现问题。

优化 Hadoop_Heapsize 的内存配置还需要结合其他相关参数进行调整,调整垃圾回收机制、优化缓存设置等,都可以在一定程度上提高内存的使用效率,降低对内存的需求。

判断 Hadoop_Heapsize 对内存要求是否高,不能一概而论,需要综合考虑业务需求、数据规模、硬件环境以及相关参数的配置等多方面因素,进行合理的调整和优化,才能使 Hadoop 系统在满足性能要求的同时,有效地利用内存资源。

文章参考来源:Hadoop 官方文档及相关技术论坛。