破解 PyTorch 分布式的性能难题

在当今的技术领域,PyTorch 分布式计算已成为众多开发者关注的焦点,其性能瓶颈问题却困扰着许多人。

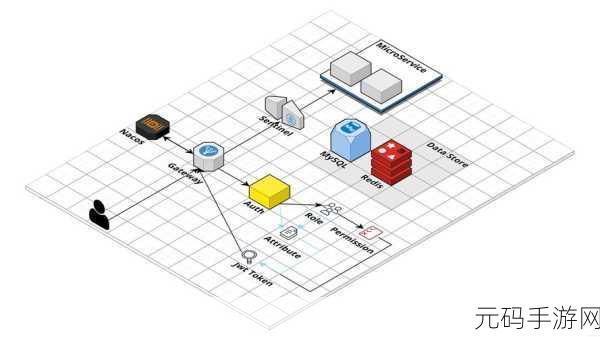

要深入理解 PyTorch 分布式性能瓶颈,我们需先明确其分布式架构的特点,PyTorch 的分布式架构旨在实现高效的并行计算,但在实际应用中,可能会因为网络延迟、数据同步等因素导致性能下降。

通信开销是造成性能瓶颈的重要原因之一,在分布式环境中,节点之间需要频繁地进行数据交换和通信,如果通信效率低下,就会极大地影响整体性能,当数据量较大且网络带宽有限时,通信时间会显著增加。

计算资源的分配不均也会带来问题,如果某些节点承担了过多的计算任务,而其他节点处于闲置状态,那么整个系统的效率就无法得到充分发挥,这就需要我们在部署分布式计算时,合理地分配计算资源。

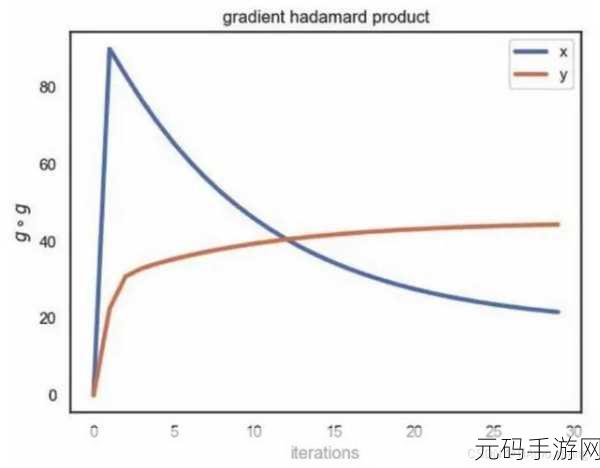

模型的复杂度和规模也可能成为性能瓶颈的因素,过于复杂的模型可能会导致计算量过大,从而增加计算时间和能耗。

为了解决 PyTorch 分布式性能瓶颈,我们可以采取一系列措施,优化通信协议,减少数据传输量和通信次数是一个有效的方法,合理调整计算资源的分配,确保各个节点的负载均衡,对于模型本身,进行适当的简化和压缩,在不损失太多精度的前提下提高计算效率。

解决 PyTorch 分布式性能瓶颈需要综合考虑多个因素,并采取针对性的优化策略,才能充分发挥其分布式计算的优势,为相关应用带来更好的性能表现。

参考来源:相关技术论坛及官方文档。