探秘 Pytorch 张量内存管理的奥秘

Pytorch 作为深度学习领域的重要框架,张量内存管理是其核心环节之一,深入理解和掌握这一机制,对于优化模型性能、提高资源利用率至关重要。

在 Pytorch 中,张量内存的分配和释放是由系统自动完成的,但我们仍能通过一些策略来进行有效的干预和优化。

内存管理的关键在于合理规划张量的使用,避免不必要的张量创建和复制,尽量复用已有的内存空间,要注意张量的大小和形状,过大或过小的张量都可能影响性能。

Pytorch 提供了一些工具和方法来帮助我们监控和管理张量内存,通过使用torch.cuda.memory_allocated 等函数,可以获取当前已分配的内存量,从而及时发现内存泄漏等问题。

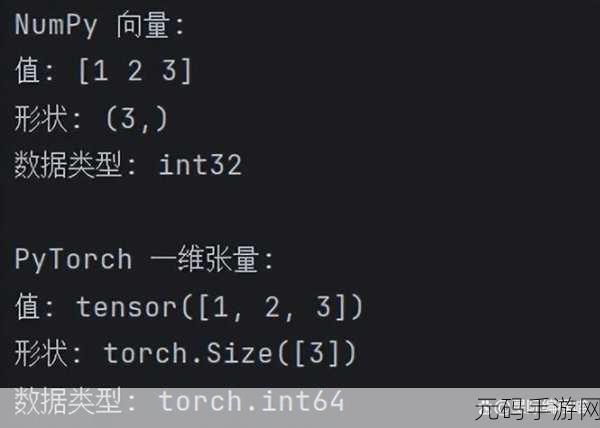

数据类型的选择也会对内存占用产生影响,合理选择精度较低的数据类型,如float16 而非float32,在不影响精度的前提下能够减少内存消耗。

在实际应用中,还可以结合模型的特点和硬件环境,采用诸如内存池、缓存等技术,进一步提升内存管理的效率。

深入研究和掌握 Pytorch 张量内存管理,是提升深度学习模型性能和效率的重要途径。

参考来源:相关 Pytorch 官方文档及技术论坛讨论。