掌握 Hadoop 核心组件配置秘籍,开启高效数据处理之旅

Hadoop 作为大数据领域的重要技术框架,其核心组件的配置至关重要,正确的配置不仅能够提升系统性能,还能确保数据处理的准确性和高效性。

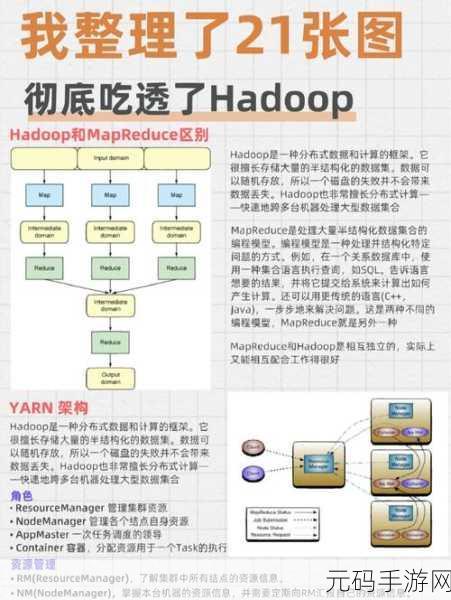

Hadoop 核心组件主要包括 HDFS(Hadoop 分布式文件系统)、YARN(资源管理框架)和 MapReduce(分布式计算框架),HDFS 负责数据的存储和管理,YARN 用于资源的分配和调度,MapReduce 则承担着数据的计算任务。

在进行 Hadoop 核心组件配置时,需要充分考虑硬件资源、业务需求和数据规模等因素,首先是硬件资源,如果服务器的内存、CPU 和存储容量有限,就需要合理调整配置参数,以避免资源浪费或不足,其次是业务需求,不同的业务场景对数据处理的实时性、准确性和并发度要求不同,配置也应相应调整,再者是数据规模,大规模数据处理需要更强大的配置来保障性能。

对于 HDFS 的配置,重点关注副本数量、块大小和存储策略等参数,副本数量的设置要根据数据的重要性和存储成本来权衡,块大小的选择会影响数据的读写性能,通常需要根据数据的特点和网络带宽进行优化,存储策略则决定了数据在集群中的分布方式,以实现负载均衡和高可用性。

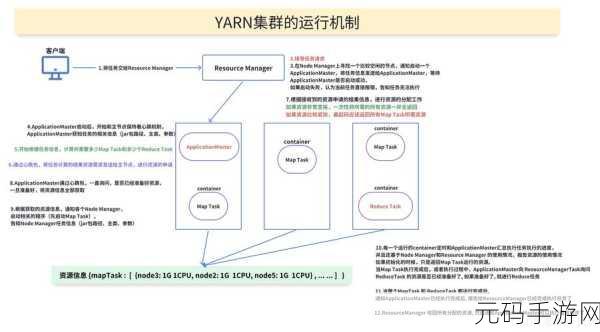

YARN 的配置主要涉及资源池的划分、内存和 CPU 资源的分配等,合理划分资源池可以满足不同类型任务的需求,避免资源竞争,精确的内存和 CPU 资源分配能够提高资源利用率,减少任务等待时间。

MapReduce 的配置包括任务并行度、缓存大小和排序缓冲区等参数,通过调整任务并行度,可以充分利用集群的计算能力,合适的缓存大小和排序缓冲区设置能够提升数据处理的效率。

要做好 Hadoop 核心组件的配置,需要深入了解各个组件的工作原理和特点,结合实际的业务场景和硬件环境,进行不断的测试和优化,只有这样,才能构建出高效、稳定的 Hadoop 大数据处理平台,为企业的业务发展提供有力支持。

文章参考来源:相关技术文档及大数据领域的专业研究。

上一篇:原神荒泷一斗圣遗物选择全攻略

下一篇:最强祖师深度玩法技巧与最新资讯