探秘 Spark 数据库,能否胜任复杂分析的关键所在

在当今数字化时代,数据的处理和分析变得愈发重要,而 Spark 数据库作为一种强大的数据处理工具,其能否支持复杂分析成为了众多开发者和数据分析师关注的焦点。

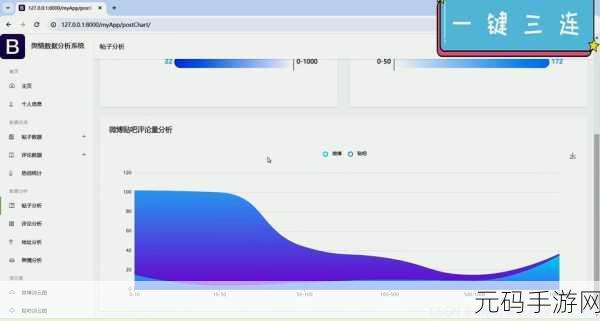

Spark 数据库具备出色的性能和扩展性,这为处理大规模数据提供了坚实基础,面对复杂的分析需求,它是否能够真正应对自如呢?

要评估 Spark 数据库对复杂分析的支持能力,首先需要了解复杂分析的特点和要求,复杂分析通常涉及多个数据源的整合、深度的数据挖掘以及复杂的算法应用,这就要求数据库具备高效的数据读取和处理速度,以及强大的计算能力。

Spark 数据库在数据读取方面表现优异,它能够快速从各种存储系统中获取数据,无论是传统的关系型数据库,还是新兴的分布式文件系统,这使得在处理大规模数据时,能够节省大量的时间成本。

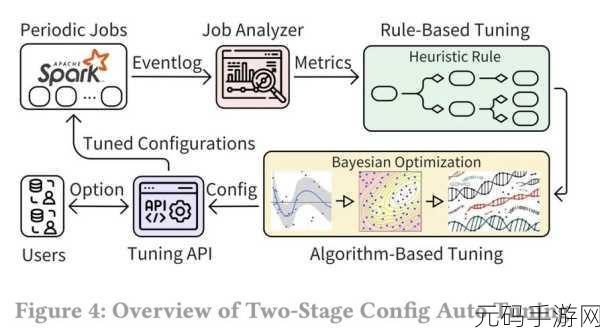

在计算能力方面,Spark 数据库拥有丰富的计算引擎和优化策略,通过分布式计算的方式,可以将复杂的计算任务分配到多个节点上并行处理,大大提高了计算效率。

Spark 数据库也并非完美无缺,在处理某些特定类型的复杂分析任务时,可能会遇到一些挑战,对于实时性要求极高的分析场景,可能需要进一步优化配置和调整策略。

Spark 数据库在支持复杂分析方面具有显著的优势,但也需要根据具体的应用场景进行合理的配置和优化,只有这样,才能充分发挥其潜力,为数据处理和分析提供强大的支持。

文章参考来源:相关技术文档及行业研究报告。