突破瓶颈!PyTorch 模型训练准确率飙升秘籍

PyTorch 模型训练,是众多开发者和研究人员关注的焦点,如何提升其准确率,更是大家一直努力探索的关键。

在模型训练过程中,数据的质量和预处理至关重要,高质量且经过合理预处理的数据,能够为模型的学习提供坚实的基础,数据清洗、归一化、增强等操作,都能有效改善数据的质量,从而提升模型对不同情况的适应性。

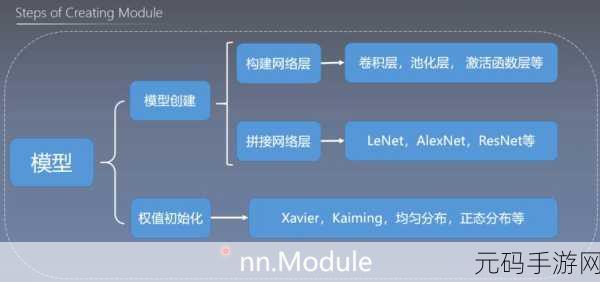

模型的架构设计直接影响着准确率的上限,选择合适的网络结构、层数、神经元数量等,需要根据具体的任务和数据特点进行精心调整,对于图像识别任务,卷积神经网络往往能发挥出色的性能;而对于序列数据处理,循环神经网络则可能更为适用。

优化算法的选择对于准确率的提升也不容忽视,常见的优化算法如随机梯度下降(SGD)、Adagrad、Adadelta 等,它们在不同场景下的表现各有优劣,需要根据模型的特点和数据的分布,选择最适合的优化算法,并合理调整其参数。

超参数的调优是一个反复试验的过程,学习率、正则化参数、迭代次数等超参数的设置,对模型的训练效果有着显著的影响,通过不断的试验和对比,找到最优的超参数组合,能够使模型达到更好的准确率。

训练环境的设置也会对结果产生影响,合理分配计算资源、选择合适的硬件设备,能够提高训练效率,为模型的优化提供更多的可能性。

提升 PyTorch 模型训练的准确率并非一蹴而就,需要综合考虑数据、模型架构、优化算法、超参数调优以及训练环境等多个方面,只有在各个环节都做到精心设计和优化,才能让模型在实际应用中展现出更高的准确性和可靠性。

文章参考来源:相关技术论坛及专业书籍。