深入探究,Spark SortBy 应对海量数据的秘籍

在当今数字化时代,数据量的爆炸式增长已成为常态,对于处理大规模数据的需求日益迫切,而 Spark SortBy 在这方面扮演着重要角色。

Spark SortBy 是 Spark 框架中用于对数据进行排序的操作,当面对海量数据时,它的性能和效率至关重要,Spark SortBy 究竟是如何在大数据量的情况下展现出色表现的呢?

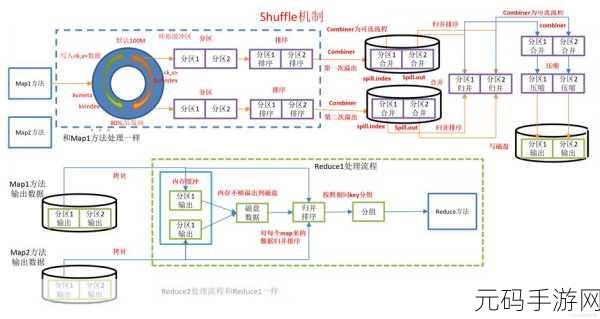

要理解 Spark SortBy 处理大数据量的方式,我们得先从它的基本原理说起,Spark SortBy 采用了分布式计算的思想,将数据分割成多个分区,并在各个节点上并行处理排序任务,这种分布式的处理方式极大地提高了处理速度,能够应对大规模的数据量。

我们看看 Spark SortBy 的优化策略,合理调整分区数量是关键之一,通过根据数据的特点和集群的资源状况,选择合适的分区数量,可以有效减少数据倾斜和提高排序效率。

还有,内存管理在 Spark SortBy 处理大数据量时也起着举足轻重的作用,合理分配内存资源,避免内存溢出和频繁的垃圾回收,能够保障排序过程的稳定和高效。

选择合适的数据结构也能提升 Spark SortBy 的性能,使用高效的排序算法和数据存储结构,可以加快排序的速度。

Spark SortBy 在处理大数据量时,通过分布式计算、优化分区、精细的内存管理以及合适的数据结构选择等多种手段,展现出强大的能力,深入了解和掌握这些技巧,将有助于我们在大数据处理中更加得心应手。

文章参考来源:相关技术文档及 Spark 官方网站。