探索 Hadoop 核心组件的创新应用之道

Hadoop 作为大数据领域的重要技术框架,其核心组件的应用一直备受关注,如何实现这些组件的创新应用,成为众多开发者和企业探索的关键。

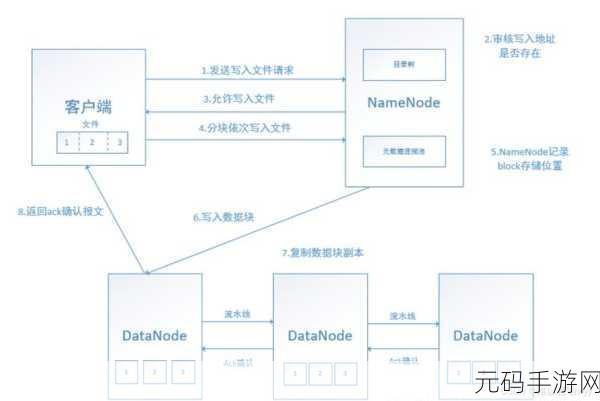

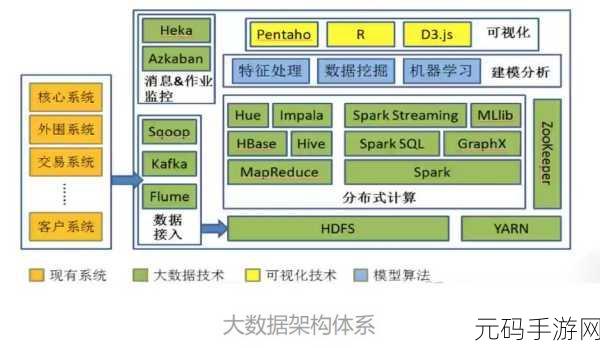

Hadoop 的核心组件包括 HDFS(Hadoop 分布式文件系统)、MapReduce(分布式计算模型)和 YARN(资源管理框架)等,HDFS 提供了高可靠、高容错的海量数据存储能力;MapReduce 则实现了大规模数据的并行处理;YARN 负责资源的调度和管理,确保系统的高效运行。

要实现 Hadoop 核心组件的创新应用,关键在于深入理解其工作原理和特点,开发者需要结合具体的业务需求,灵活运用这些组件的功能,在处理海量图像数据时,可以利用 HDFS 的分布式存储优势,将图像数据分散存储在多个节点上,提高数据的访问速度和可靠性,通过 MapReduce 对图像数据进行特征提取和分类处理,实现高效的图像分析。

技术的不断发展也为 Hadoop 核心组件的创新应用提供了新的机遇,随着云计算技术的普及,Hadoop 可以与云平台相结合,实现弹性扩展和资源的优化配置,利用容器技术,可以更方便地部署和管理 Hadoop 集群,提高系统的灵活性和可维护性。

在实际应用中,还需要注重数据的质量和安全性,确保输入数据的准确性和完整性,对于 Hadoop 核心组件的有效运行至关重要,采取严格的安全措施,保护数据的隐私和机密性,防止数据泄露和恶意攻击。

Hadoop 核心组件的创新应用需要开发者具备扎实的技术功底、敏锐的业务洞察力和创新思维,只有不断探索和实践,才能充分发挥 Hadoop 在大数据处理中的巨大潜力,为企业和社会创造更多的价值。

参考来源:相关技术文档及行业研究报告。