探索 PyTorch 图神经网络中神奇的激活函数

在当今的科技领域,图神经网络的发展备受瞩目,而 PyTorch 作为强大的深度学习框架,其图神经网络中的激活函数更是关键所在。

激活函数在 PyTorch 图神经网络中扮演着至关重要的角色,它决定了神经元的输出,从而影响整个网络的学习能力和表达能力,不同的激活函数具有不同的特性,能够适应不同的任务和数据特点。

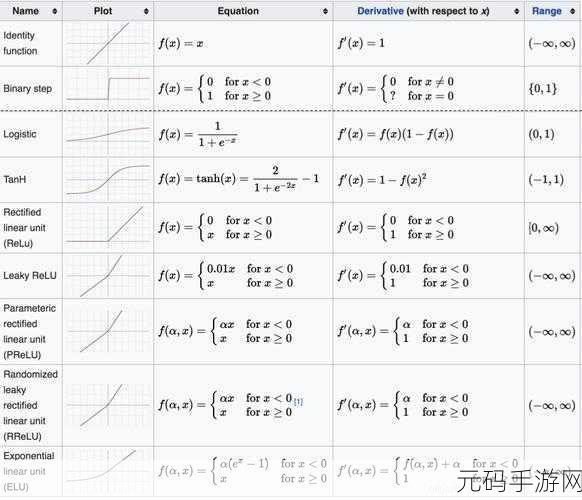

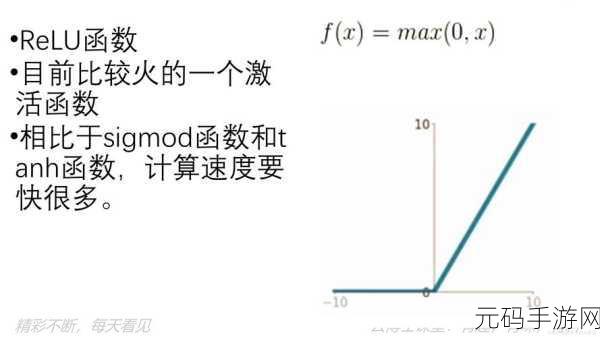

常见的 PyTorch 图神经网络激活函数包括 ReLU、Sigmoid、Tanh 等,ReLU 函数因其简单高效,在很多情况下成为首选,它能够有效地解决梯度消失问题,加快网络的训练速度,Sigmoid 函数则将输出值限制在 0 到 1 之间,常用于二分类问题,Tanh 函数的输出值范围在 -1 到 1 之间,具有更好的对称性。

在选择激活函数时,需要考虑多方面因素,数据的分布特点是重要的考量之一,如果数据集中存在大量的负值,ReLU 可能不太适用,而 Tanh 可能更合适,网络的结构和深度也会影响激活函数的选择,较深的网络可能更倾向于使用能够缓解梯度消失的激活函数。

还可以通过组合不同的激活函数来提升网络的性能,在某些层使用 ReLU,在其他层使用 Tanh,以充分发挥它们各自的优势。

深入理解和合理选择 PyTorch 图神经网络的激活函数,对于构建高效、准确的模型具有重要意义。

文章参考来源:相关深度学习技术文献及 PyTorch 官方文档。