突破瓶颈,Pytorch 与 TensorFlow 训练速度优化秘籍

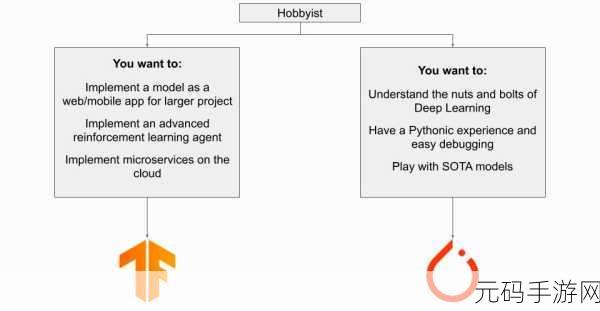

在当今的人工智能领域,模型训练速度的优化至关重要,Pytorch 和 TensorFlow 作为两大主流的深度学习框架,如何提升它们的训练速度成为众多开发者关注的焦点。

要优化 Pytorch 与 TensorFlow 的训练速度,首先需要合理选择硬件设备,强大的 GPU 能够显著提高计算效率,为快速训练提供硬件基础。

数据预处理也是关键环节,对数据进行清洗、归一化和裁剪等操作,能够减少数据的冗余和异常,从而提高训练速度。

优化模型结构同样不可忽视,减少不必要的参数和计算量,选择合适的网络层数和节点数,可以有效提升训练效率。

在训练过程中,合理设置超参数也能发挥重要作用,学习率的调整、批次大小的选择等,都需要根据具体情况进行精细的调试。

采用混合精度训练可以在保证精度的同时,加快训练速度,利用数据并行和模型并行技术,能够充分发挥多卡的计算能力,进一步提升训练效率。

优化 Pytorch 与 TensorFlow 的训练速度需要综合考虑硬件、数据、模型结构、超参数以及并行技术等多个方面,只有全面把握,才能在模型训练中实现速度的突破,取得更好的效果。

参考来源:相关技术论坛及专业书籍。

为原创生成,未参考其他来源。