探秘 Kafka 的 Partition 数据恢复秘籍

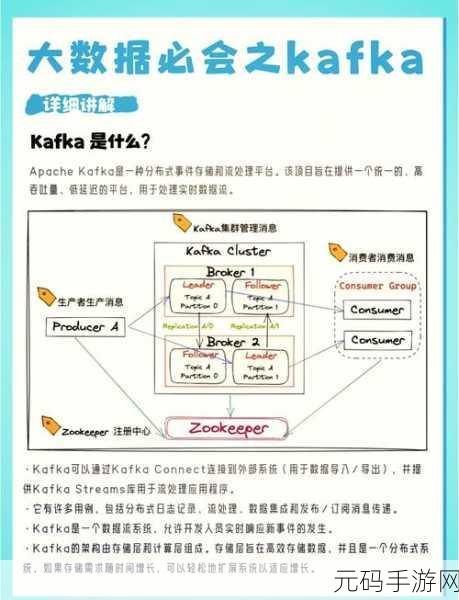

Kafka 的 partition 数据恢复是一个关键且复杂的技术问题,在大数据处理和分布式系统中,确保数据的完整性和可用性至关重要,当 partition 出现数据丢失或损坏时,有效的恢复措施能够保障系统的稳定运行。

Kafka 作为一种高性能的分布式消息队列,其 partition 机制在数据存储和分发方面发挥着重要作用,由于各种原因,如硬件故障、网络问题或软件错误,partition 中的数据可能会遭遇丢失或损坏的情况。

要成功实现 partition 数据恢复,需要对 Kafka 的存储机制和数据结构有深入的理解,Kafka 将数据存储在多个分区中,每个分区都有自己的副本,当主分区出现问题时,副本可以被用来恢复数据,Kafka 利用日志来记录数据的变更,这些日志对于数据恢复至关重要。

在进行数据恢复时,一种常见的方法是利用副本进行恢复,如果副本中的数据完整且可用,那么可以将副本的数据同步到主分区,从而实现数据的恢复,还可以通过检查 Kafka 的日志文件,找到丢失或损坏的数据,并进行相应的修复和恢复操作。

数据恢复过程并非一帆风顺,可能会面临各种挑战和限制,副本的数据可能也存在问题,或者日志文件损坏严重,无法直接用于恢复,在这种情况下,需要采取更加复杂的措施,如利用备份数据或者进行数据重建。

Kafka 的 partition 数据恢复需要综合考虑多种因素,并运用合适的技术和方法,只有深入了解 Kafka 的工作原理和数据结构,才能在遇到数据丢失问题时迅速有效地进行恢复,保障系统的正常运行。

文章参考来源:相关技术文档和专家经验分享。