探秘 Spark 计算框架,高效计算的秘密武器

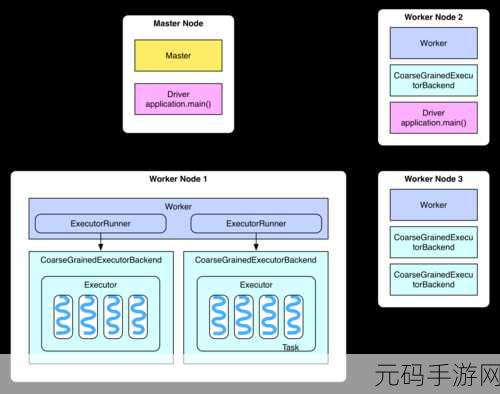

Spark 计算框架作为大数据处理领域的重要工具,其提升计算效率的能力备受关注,它究竟是如何实现高效计算的呢?

Spark 计算框架之所以能够显著提升计算效率,关键在于其独特的设计和优化策略,首先是基于内存的计算模式,它将数据尽可能地存储在内存中,大大减少了磁盘 I/O 操作,从而显著加快了数据处理速度,Spark 具备出色的任务调度和资源管理机制,它能够根据任务的优先级和资源需求,合理分配计算资源,确保各个任务能够高效执行,Spark 支持多种数据格式和数据源,能够灵活处理各种类型的数据,提高了数据处理的通用性和效率。

在数据处理方面,Spark 提供了丰富的 API 和高级操作,如 DataFrame 和 Dataset 等,使得开发者能够以更简洁、高效的方式编写数据处理逻辑,Spark 的缓存机制也发挥了重要作用,通过将经常使用的数据进行缓存,可以避免重复计算,进一步提升计算效率。

Spark 还拥有强大的容错能力,在分布式计算环境中,节点故障是不可避免的,但 Spark 能够自动检测和处理这些故障,确保计算任务的可靠性和稳定性,不会因为个别节点的问题而导致整个计算任务的失败。

Spark 计算框架通过一系列创新的技术和优化手段,成功提升了计算效率,为大数据处理和分析带来了更高效、更可靠的解决方案。

文章参考来源:相关技术文档和行业研究报告。