探秘 HBase MLlib 模型评估的关键技巧

在当今数据驱动的时代,HBase MLlib 模型评估成为众多开发者关注的焦点,模型评估是衡量模型性能和有效性的重要环节,对于优化模型、提升预测准确性具有关键意义。

HBase MLlib 模型评估涉及多个方面的考量,数据的质量和代表性是首要因素,高质量且具有代表性的数据能够为模型评估提供坚实基础,如果数据存在偏差、缺失或错误,那么评估结果的可靠性就会大打折扣。

评估指标的选择同样至关重要,常见的评估指标包括准确率、召回率、F1 值等,不同的指标适用于不同的场景和问题,需要根据具体的业务需求和模型特点来确定,在垃圾邮件分类问题中,召回率可能更为重要;而在信用评估中,准确率则可能是关键指标。

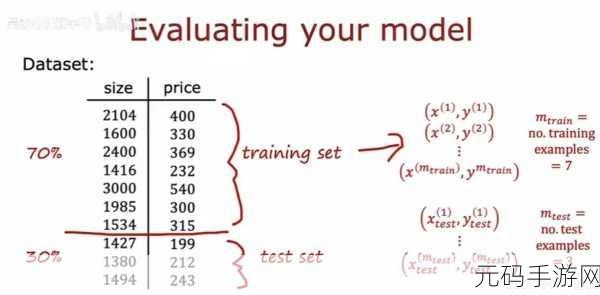

模型的过拟合和欠拟合也是评估中需要重点关注的问题,过拟合意味着模型对训练数据过度学习,在新数据上的表现不佳;欠拟合则表示模型未能充分捕捉数据中的模式和规律,通过交叉验证等技术,可以有效地检测和避免这两种情况。

可视化工具的运用能够帮助我们更直观地理解模型的性能,通过绘制ROC 曲线、混淆矩阵等,能够清晰地展示模型在不同阈值下的表现,从而辅助我们做出更准确的评估和决策。

HBase MLlib 模型评估是一个综合性的工作,需要综合考虑数据、指标、过拟合与欠拟合问题以及可视化等多个方面,只有深入理解和掌握这些要点,才能确保模型的有效性和实用性,为实际应用提供可靠的支持。

参考来源:相关技术文档及行业研究报告。