Python3 爬虫规避 IP 封禁秘籍大揭秘

在当今的网络世界中,Python3 爬虫的应用越来越广泛,但如何避免 IP 被封却成为了困扰许多开发者的难题,让我们一同深入探讨这个关键问题,为您揭开其中的神秘面纱。

中心句:Python3 爬虫在广泛应用的同时,避免 IP 被封是个难题。

要有效地避免 Python3 爬虫的 IP 被封,我们首先要清晰地认识到造成 IP 封禁的常见原因,过于频繁的请求是一个重要因素,如果爬虫在短时间内对目标网站发送大量请求,这很容易引起网站的警觉,从而导致 IP 被封,不遵循网站的规则和协议也是导致封禁的常见原因之一,有些网站明确禁止爬虫行为,或者对爬虫的访问频率、方式等有严格的规定,如果我们无视这些规则,自然会面临被封的风险。

中心句:造成 Python3 爬虫 IP 封禁的常见原因包括频繁请求和不遵循网站规则。

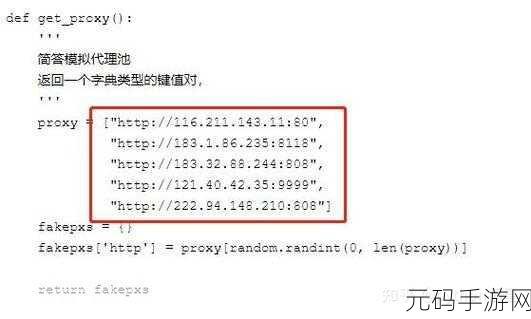

如何才能有效地解决这些问题呢?合理控制请求频率是关键的一步,我们可以通过设置适当的时间间隔来发送请求,模拟人类正常的访问行为,这样能够大大降低被网站识别为爬虫的可能性,使用代理 IP 也是一种常见且有效的方法,通过不断切换代理 IP,能够避免单个 IP 发送过多请求而被封禁,还可以在爬虫程序中加入随机的用户代理头信息,让网站难以识别出这是由同一爬虫发出的请求。

中心句:解决 Python3 爬虫 IP 被封问题的方法包括合理控制请求频率、使用代理 IP 和加入随机用户代理头信息。

除此之外,我们还需要注意一些细节,在编写爬虫程序时,要对异常情况进行妥善处理,如果遇到网站返回错误代码或者访问受限的提示,要及时停止当前操作,避免进一步触发封禁机制,定期检查和更新爬虫程序,以适应目标网站可能的规则变化,也是非常重要的。

中心句:避免 Python3 爬虫 IP 被封还需注意处理异常情况和定期更新程序等细节。

避免 Python3 爬虫的 IP 被封并非一蹴而就的事情,需要我们综合运用多种方法和策略,并且时刻保持警惕,关注目标网站的变化,只有这样,我们才能在合法合规的前提下,顺利地进行爬虫工作。

为原创,未参考其他来源。