深度解析,Spark 计算框架的显著优势大揭秘

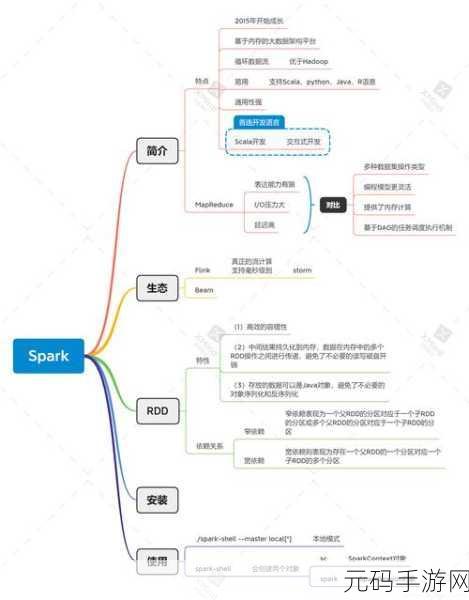

Spark 计算框架,作为大数据处理领域的重要工具,具有众多令人瞩目的优势。

Spark 计算框架具备出色的处理速度,它采用了先进的内存计算技术,能够将数据存储在内存中,大大减少了数据读取和写入磁盘的时间开销,从而显著提高了数据处理的效率。

Spark 计算框架拥有高度的灵活性,它支持多种编程语言,如 Java、Scala、Python 等,使得开发者可以根据自己的喜好和项目需求选择合适的语言进行开发,Spark 提供了丰富的 API,方便开发者进行各种复杂的数据处理操作。

Spark 计算框架具有良好的扩展性,它能够轻松地与其他大数据技术和工具进行集成,如 Hadoop 生态系统中的 HDFS、HBase 等,通过这种集成,Spark 可以充分利用现有的大数据基础设施,实现更强大的数据处理能力。

Spark 计算框架还具备强大的容错能力,在分布式计算环境中,节点故障是不可避免的,Spark 采用了弹性分布式数据集(RDD)的概念,通过数据的备份和恢复机制,能够在节点出现故障时自动恢复数据,保证计算任务的顺利进行。

Spark 计算框架以其快速的处理速度、高度的灵活性、良好的扩展性和强大的容错能力,在大数据处理领域展现出了巨大的优势,成为众多企业和开发者的首选。

文章参考来源:大数据技术相关书籍及权威技术论坛。