探秘 PyTorch 多 GPU 训练秘籍

在当今的科技时代,深度学习的应用越来越广泛,而高效的训练模型成为了关键,PyTorch 的多 GPU 训练技术备受关注。

多 GPU 训练能够极大地提升训练效率,缩短训练时间,它允许同时利用多个 GPU 的计算能力,从而处理更复杂的任务和更大规模的数据。

要实现 PyTorch 的多 GPU 训练,首先需要确保您的硬件环境支持多个 GPU 并且正确安装了相关的驱动程序,在代码层面,需要使用 PyTorch 提供的特定函数和模块来进行配置和优化。

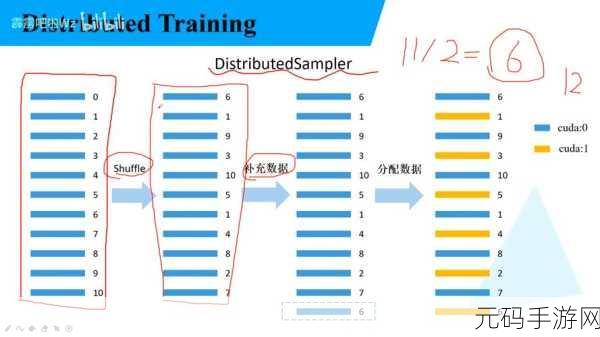

在数据加载方面,需要合理地划分数据并分配到不同的 GPU 上,以实现并行处理,对于模型的定义和参数设置,也需要根据多 GPU 的特点进行调整,以充分发挥其优势。

在训练过程中,还需要注意数据的同步和模型参数的更新策略,以保证各个 GPU 之间的协同工作,避免出现偏差和错误。

对于不同的应用场景和模型结构,可能需要针对性地调整多 GPU 训练的参数和策略,以达到最佳的训练效果。

掌握 PyTorch 的多 GPU 训练技术对于深度学习的研究和应用具有重要意义,通过合理的配置和优化,能够显著提升训练效率,为解决更复杂的问题提供有力支持。

参考来源:深度学习相关技术文档及 PyTorch 官方教程。