探秘 Pytorch 分布式部署的错误根源

在当今的科技领域,Pytorch 作为一款强大的深度学习框架,被广泛应用于各种项目中,其分布式部署却常常出现错误,给开发者带来了不小的困扰。

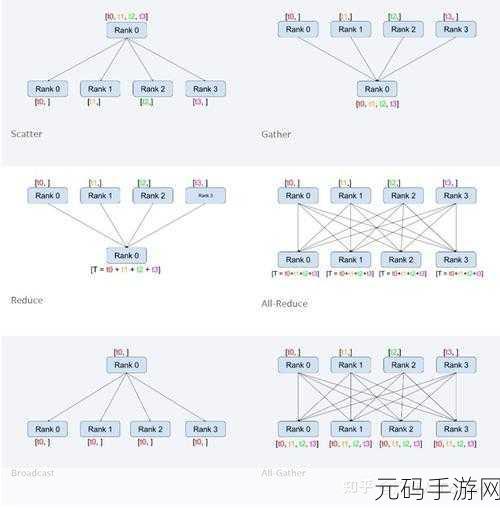

Pytorch 分布式部署出错的原因多种多样,网络通信问题是较为常见的一个因素,在分布式环境中,节点之间需要频繁地进行数据交换和通信,如果网络环境不稳定或者带宽不足,就很容易导致通信错误。

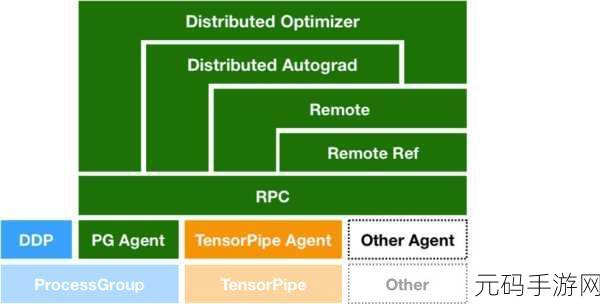

配置不当也是导致出错的重要原因,包括硬件配置、软件环境配置以及 Pytorch 自身的参数设置等方面,不同节点的硬件性能差异较大,或者软件版本不兼容,都可能引发部署错误。

代码实现的错误也不容忽视,开发者在编写分布式部署的相关代码时,如果没有遵循 Pytorch 的规范和最佳实践,或者存在逻辑漏洞,同样会导致部署失败。

要解决 Pytorch 分布式部署出错的问题,首先需要对网络进行优化,确保网络的稳定性和带宽能够满足数据通信的需求,可以通过升级网络设备、优化网络拓扑结构等方式来实现。

要仔细检查配置信息,对硬件、软件以及 Pytorch 的参数进行全面的检查和调试,确保各个环节的配置都正确无误。

要注重代码的质量,遵循 Pytorch 的开发规范,进行严格的代码审查和测试,及时发现并修复代码中的错误。

解决 Pytorch 分布式部署出错的问题需要综合考虑多个方面,从网络、配置到代码实现,每一个环节都不能忽视,只有这样,才能确保分布式部署的顺利进行,为深度学习项目的开展提供有力的支持。

文章参考来源:相关技术论坛及官方文档。