掌握秘诀!优化 PyTorch 卷积神经网络的关键策略

PyTorch 卷积神经网络的优化是众多开发者和研究者关注的重要课题,想要实现更出色的性能和效果,需要深入理解并运用一系列的优化技巧。

优化 PyTorch 卷积神经网络,数据预处理至关重要,对输入数据进行标准化、归一化等操作,能够提升模型的训练效率和稳定性,合理的数据增强手段,如翻转、旋转、裁剪等,可以增加数据的多样性,避免模型过拟合。

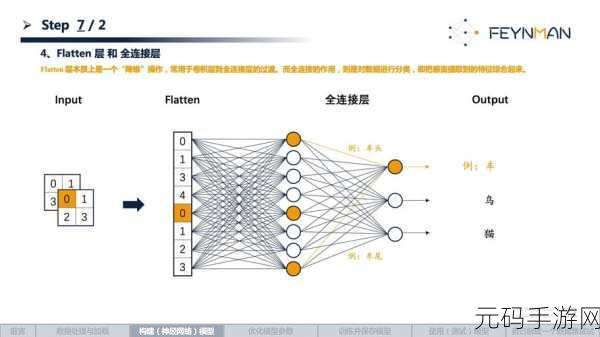

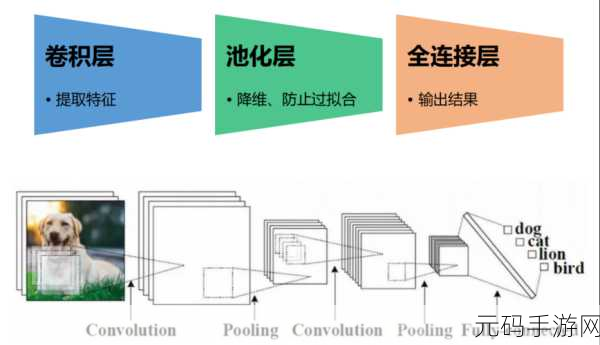

模型结构的设计也影响着优化效果,选择合适的卷积核大小、层数以及通道数,能够平衡模型的复杂度和性能,引入残差连接、密集连接等结构,可以加强特征的传递和复用,提高模型的表达能力。

优化算法的选择同样关键,常见的随机梯度下降(SGD)及其变种,如 Adagrad、Adadelta、Adam 等,各有特点,根据模型和数据的特点,选择合适的优化算法能加快收敛速度,提高训练效果。

超参数的调整需要耐心和经验,学习率、正则化参数等的设置对模型性能有显著影响,通过试验不同的取值,找到最优的超参数组合,是优化过程中的重要步骤。

训练技巧也不容忽视,采用早停法,在验证集误差不再下降时停止训练,避免过度训练,使用批量归一化(Batch Normalization)可以加速训练,并减少内部协变量偏移。

优化 PyTorch 卷积神经网络是一个综合性的任务,需要从数据预处理、模型结构、优化算法、超参数调整和训练技巧等多个方面入手,不断尝试和改进,才能达到理想的效果。

参考来源:相关学术文献及开发经验总结