探索 Hadoop Flink 数据流向的奥秘

在当今数字化时代,数据处理和分析成为了企业和组织发展的关键,Hadoop 和 Flink 作为大数据处理领域的重要技术,其数据流向的理解至关重要。

Hadoop 以其分布式存储和计算能力而闻名,而 Flink 则在实时数据处理方面表现出色,这两者之间的数据流向究竟是怎样的呢?

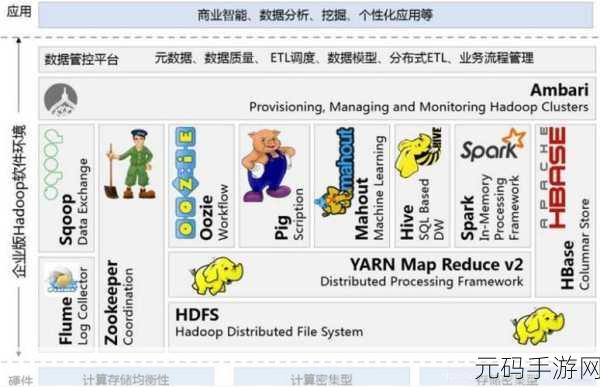

要弄清楚 Hadoop Flink 数据流向,首先需要了解它们各自的工作原理,Hadoop 基于 MapReduce 模型,将大规模数据分成小块进行处理,而 Flink 则采用了流处理的方式,能够实时处理不断产生的数据。

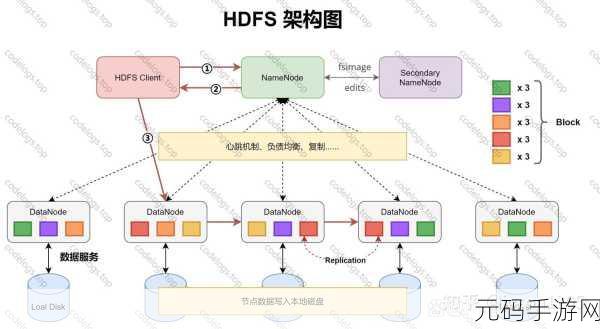

Hadoop 中的数据通常存储在 HDFS(Hadoop 分布式文件系统)中,通过 MapReduce 任务进行计算和处理,而 Flink 可以直接从数据源获取数据,并以高效的方式进行处理和分析。

在数据流向方面,Hadoop 往往用于大规模数据的批处理,处理后的结果可能会被 Flink 进一步实时分析和处理,一些历史数据在 Hadoop 中进行预处理,然后实时产生的数据由 Flink 进行快速处理和响应。

数据在 Hadoop 和 Flink 之间的传输也需要考虑数据格式的兼容性和转换,确保数据能够在两个系统之间顺利流动,并且保持数据的准确性和完整性。

理解 Hadoop Flink 数据流向对于充分发挥它们在大数据处理中的优势具有重要意义,通过合理的架构设计和数据流程规划,可以实现高效的数据处理和分析,为企业和组织带来更大的价值。

文章参考来源:相关技术文档和大数据处理领域的研究资料。