探秘 Hadoop 计算框架,性能保障的关键秘籍

Hadoop 计算框架在当今大数据处理领域中扮演着至关重要的角色,其性能保障更是备受关注。

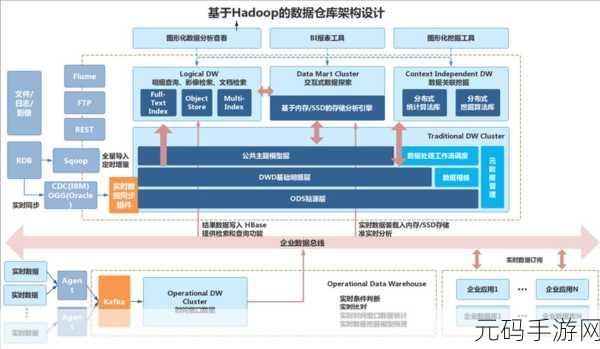

Hadoop 计算框架之所以能够在处理海量数据时展现出卓越的性能,关键在于其独特的架构设计和优化策略,Hadoop 采用了分布式存储系统 HDFS,将数据分散存储在多个节点上,实现了数据的高可用性和容错性,这意味着即使某些节点出现故障,数据依然能够被安全地访问和处理,不会导致整个系统的瘫痪。

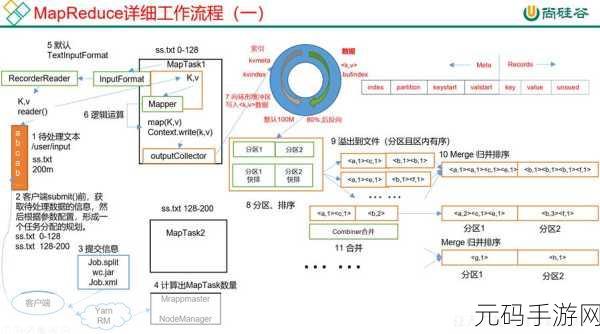

Hadoop 的计算模型 MapReduce 发挥了巨大作用,MapReduce 将复杂的计算任务分解为 Map 阶段和 Reduce 阶段,通过并行处理的方式大大提高了计算效率,在 Map 阶段,数据被并行地进行处理和转换;在 Reduce 阶段,对 Map 阶段的结果进行汇总和整合,这种分阶段的处理方式使得大规模数据的计算变得更加高效和可控。

Hadoop 还具备出色的资源管理能力,YARN(Yet Another Resource Negotiator)作为 Hadoop 的资源管理框架,能够有效地分配和管理集群中的计算资源,它根据任务的需求和优先级,为不同的应用程序分配适当的资源,确保资源的充分利用和系统的稳定运行。

为了进一步提升 Hadoop 计算框架的性能,还需要对一些参数进行优化配置,调整 Map 和 Reduce 任务的数量、设置合适的内存和 CPU 资源分配等,对数据的分区和排序策略进行优化,也能够显著提高数据处理的效率。

要保障 Hadoop 计算框架的性能,需要从多个方面入手,包括架构设计、计算模型、资源管理以及参数优化等,只有深入理解和掌握这些关键因素,才能充分发挥 Hadoop 在大数据处理中的强大优势。

参考来源:相关技术文档及行业研究报告。